发布时间:2024-02-23 23:05:04 | 责任编辑:字母汇 | 浏览量:589 次

原文始发于微信公众号(AIGC每日更新):AIGC每日播报-最新SOAT SDXL-Lightning和Stable Diffusion 3

ByteDance/SDXL-Lightning

SDXL-Lightning是一个快速生成高质量1024px图像的文本到图像生成模型。该模型从stabilityai/stable-diffusion-xl-base-1.0进行蒸馏,提供了1-step、2-step、4-step和8-step的checkpoints。模型的质量在2-step、4-step和8-step时表现出色,而1-step模型则更具实验性。此外,提供了full UNet和LoRA两种检查点,其中full UNet具有最佳质量,而LoRA模型可用于其他基础模型。使用时,请根据相应的推理步骤选择正确的检查点。最后,提供了2-Step、4-Step、8-Step UNet和LoRA的代码示例,以帮助用户进行模型加载和推理。

Stable Diffusion 3

Stable Diffusion 3的发布是一个重要的事件。这是一个新的开源文本到图像模型,它基于Diffusion Transformer架构(DiT架构),并且参数量从800M到8B不等。与其前身相比,Stable Diffusion 3在多个方面都有显著的改进,包括文本语义理解、色彩饱和度、图像构图、分辨率、类型、质感和对比度。这使得该模型成为目前最强大的文本到图像模型之一135。此外,Stable Diffusion 3还可能是专为移动设备开发的,它的AI算力消耗更低,推理速度更快1。Stable Diffusion 3目前正在接受申请使用,并将扩大测试范围1。这个新模型的发布对于那些对文本到图像生成感兴趣的人们来说是一个令人期待的消息,它将为他们提供更强大、更高质量的生成能力

Stable Diffusion 3有一些新特性。根据提供的上下文,它在处理多主题提示、图像质量和文字渲染能力方面都有显著的改进。此外,Stable Diffusion 3的架构是基于Diffusion Transformer,类似于Sora模型13。Stable Diffusion 3还被称为Stability AI最新和最强大的文本到图像模型。以上是根据上下文推测的答案,可能会有其他未提及的特性。

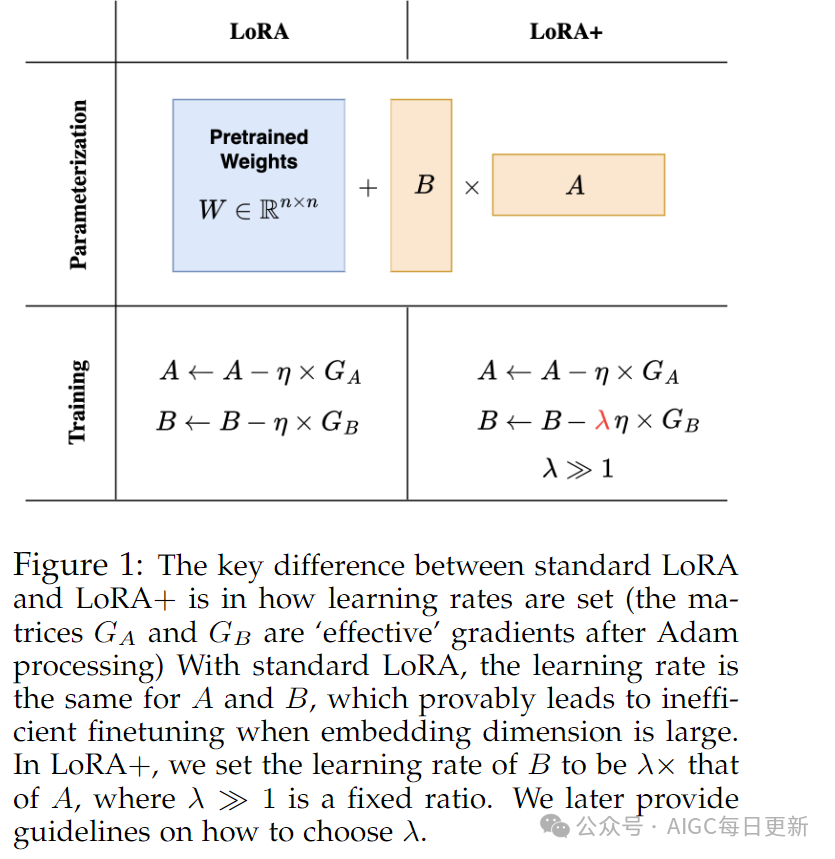

LoRA+: Efficient Low Rank Adaptation of Large Models

这篇论文研究了LoRA(Low Rank Adaptation)在大型模型微调中的表现。LoRA是一种用于微调预训练模型的方法,但原版LoRA在更新adapter矩阵时的学习率是相同的,这导致特征学习效率低下。作者提出了一种改进的LoRA+算法,通过为LoRA的adapter矩阵设置不同的学习率来解决这个问题。实验结果表明,LoRA+在性能和微调速度上都有所提升,同时保持了与原版LoRA相同的计算成本。此外,由于预训练模型的大小庞大,对于一般的小任务进行全参数微调是计算上不可行的。因此,LoRA+提供了一种有效的解决方案,可以在保持预训练模型性能的同时适应新任务。

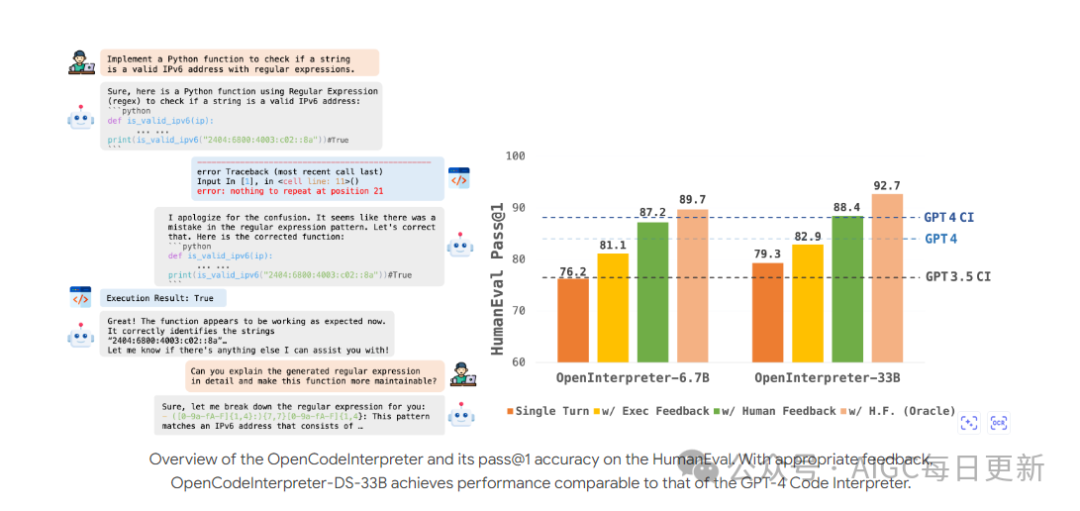

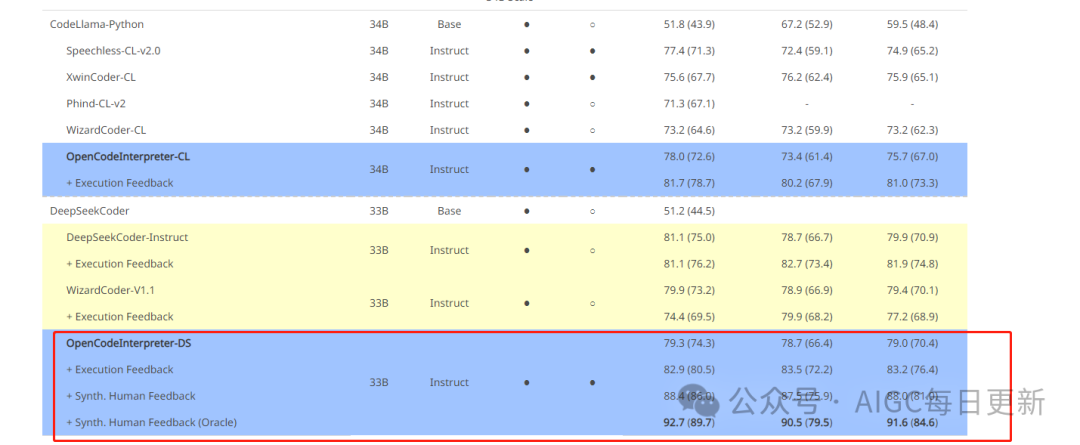

OpenCodeInterpreter: Integrating Code Generation with Execution and Refinement

类别:code模型;code interpreter

介绍了OpenCodeInterpreter,这是一个用于生成、执行和迭代优化代码的开源代码系统家族。它由Code-Feedback数据集支持,该数据集包含68K个多轮交互。OpenCodeInterpreter集成了执行和人类反馈,以实现动态代码优化。该系统在HumanEval、MBPP等关键基准测试上的全面评估显示了其卓越的性能。特别是,OpenCodeInterpreter-33B在HumanEval和MBPP的平均(和Plus版本)上实现了83.2(76.4)的准确性,与GPT-4的84.2(76.2)相媲美,并且通过来自GPT-4的人工反馈合成,进一步提高到91.6(84.6)。OpenCodeInterpreter缩小了开源代码生成模型与GPT-4 Code Interpreter等专有系统之间的差距

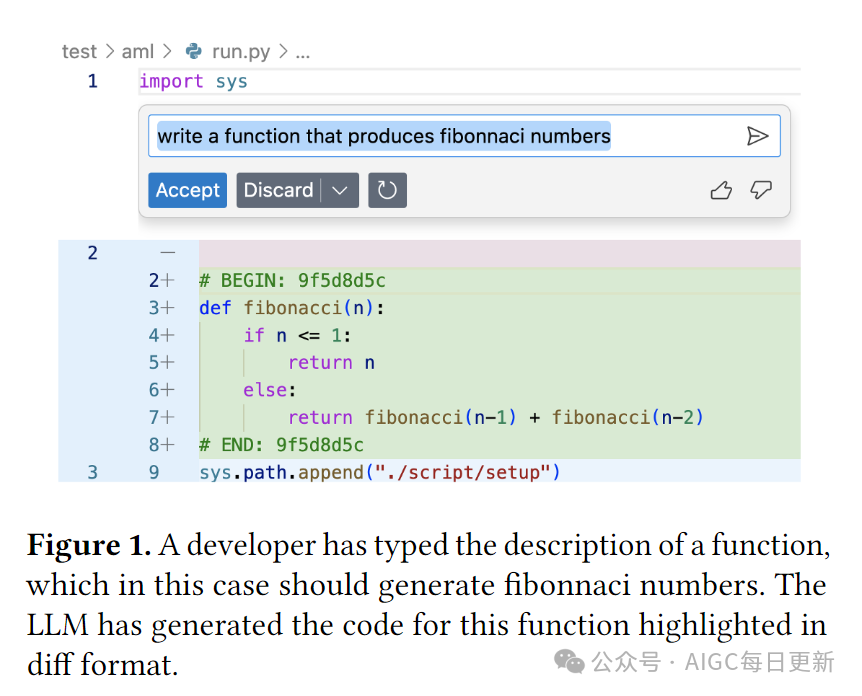

Copilot Evaluation Harness: Evaluating LLM-Guided Software Programming

介绍了一个名为Copilot评估套件的数据和工具集,用于评估LLM引导的IDE交互,涵盖各种编程场景和语言。与以前的评估系统相比,该文提出的度量标准更健壮且信息密集。该文还设计并计算了静态和执行基于的成功度量标准,以涵盖各种开发任务,包括从自然语言生成代码(generate)、从代码生成文档(doc)、生成测试用例(test)、修复bug(fix)以及工作区理解和查询解析(workspace)。这些成功度量标准旨在评估LLM在给定的IDE及其参数空间中的性能。通过使用这些度量标准评估三种常见的LLM,我们可以了解未来LLM引导的IDE场景的开发和验证情况。

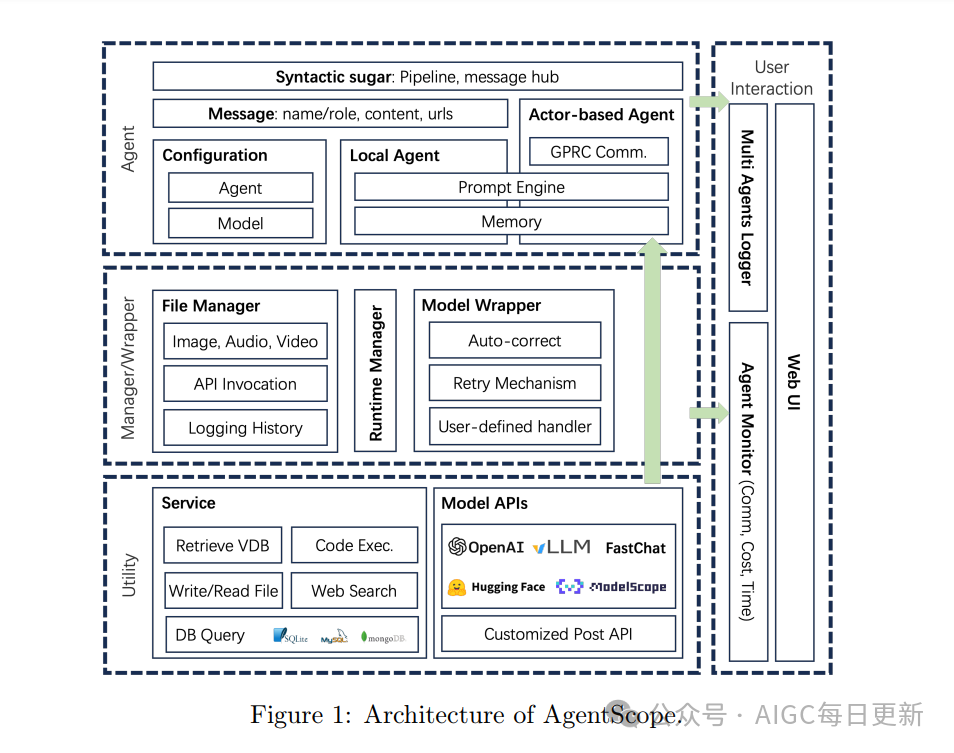

AgentScope: A Flexible yet Robust Multi-Agent Platform

AgentScope是一个创新的多代理平台,旨在使开发人员能够轻松、可靠地构建高性能的多代理应用程序。它具有三个高级功能:易于使用、高健壮性和基于Actor的分布式。它支持自定义容错控制和重试机制,以增强应用程序的稳定性。开发者可以使用纯Python编程,并提供详细的文档和示例来帮助他们入门。agentscope

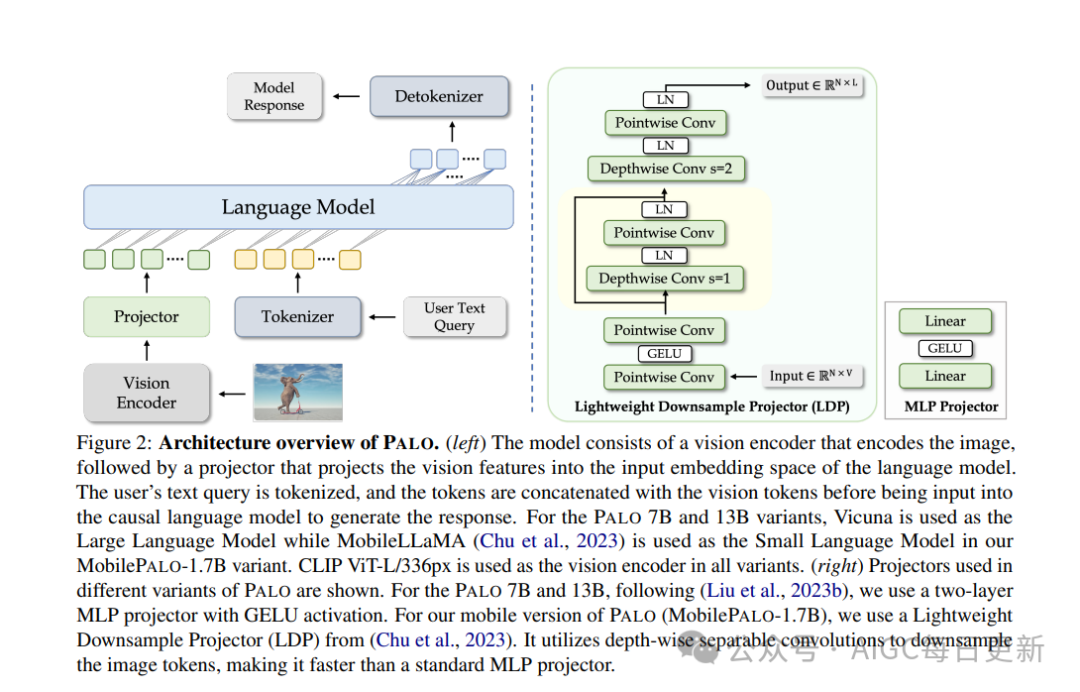

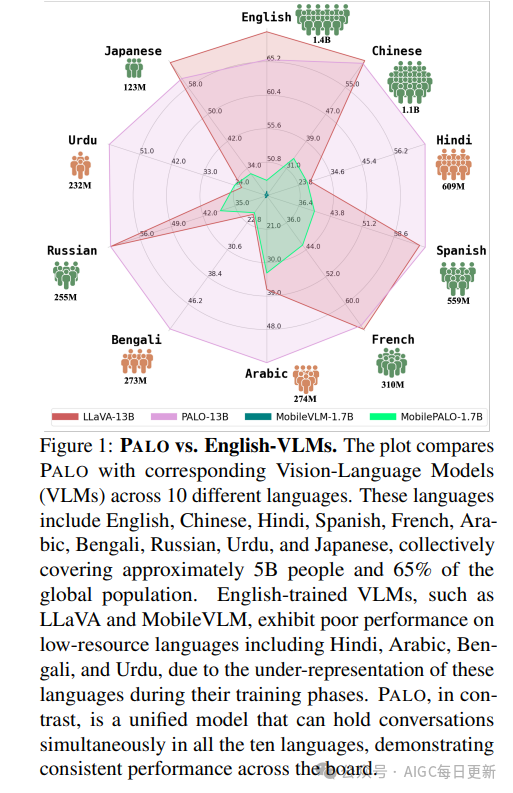

PALO: A Polyglot Large Multimodal Model for 5B People

文章介绍了Palo,一个多语言多模态模型,支持10种主要语言,包括英语、中文、西班牙语、法语、阿拉伯语、俄语、日语、印度语、孟加拉语和乌尔都语。该模型旨在为全球50亿人提供视觉推理能力,涵盖全球65%的人口。文章还提到,该模型通过半自动翻译方法,使用大型语言模型将多模态指令数据集从英语适应到目标语言,确保高语言保真度,同时实现可扩展性。此外,该模型在三个规模上进行了训练,以展示其泛化和可扩展性,并提出了第一个多语言多模态基准,以评估未来方法的视觉语言推理能力