2024KDD挑战任务,GPT-4仅得40分,Meta发布最新RAG评价基准

发布时间:2024-06-21 13:48:01 | 责任编辑:字母汇 | 浏览量:266 次

夕小瑶科技说 原创

作者 | Axe_越

众所周知,“要想富,先修路”,经常挖路的同学应该知道,要想修好一条路,首先就必须搞清楚关于道路质量的统一验收标准,否则,“我怎么知道我这条路能不能走通呢”?

对于AI领域来说,也同样如此。

还记得一年多以前,当第一批吃螃蟹的大佬们将检索增强生成(Retrieval-Augmented Generation,RAG)与LLM结合之后,由于补齐了LLM知识不足的短板,LLM立刻在各个领域的应用方面都迸发出了更大的潜力。

如今,RAG的范式已不再局限于将外部知识作为上下文补充的最传统范式,各种“联合训练”,“自我反思”,“前瞻性主动检索”方案百花齐放。然而时至今日,对于RAG对LLM的增强效果到底怎么样,仍然缺乏一个统一的验收标准。

为填补这一空缺,Meta最近发布了一套RAG评测基准,或许出乎大家的意料,哪怕是被大家公认最强的GPT-4在加上RAG之后,也仅仅只能勉强飘过40分(看了很多遍确认是百分制)!在LLM+RAG这条道路上,实际上我们还有太多值得继续探索和优化的事情。

论文标题:

CRAG - Comprehensive RAG Benchmark

论文链接:

https://arxiv.org/pdf/2406.04744

动机

自2022年底横空出世,LLM已经极大地改变了NLP领域的格局,特别是在问答任务中,它们能够处理复杂的查询并生成相关的答案。然而,LLM在生成答案时存在较为明显的“幻觉”问题,即它们可能会产生缺乏事实依据或与给定上下文不相关的答案,而这种现象在LLM涉及到不熟悉的知识或未及时更新的知识时尤为明显。

为了解决LLM的这一缺陷,检索增强生成(RAG)技术被提出,RAG系统在接收到问题后,会搜索外部信息源以检索相关信息,并据此提供有依据的答案,从而极大缓解了LLM的“幻觉”问题。

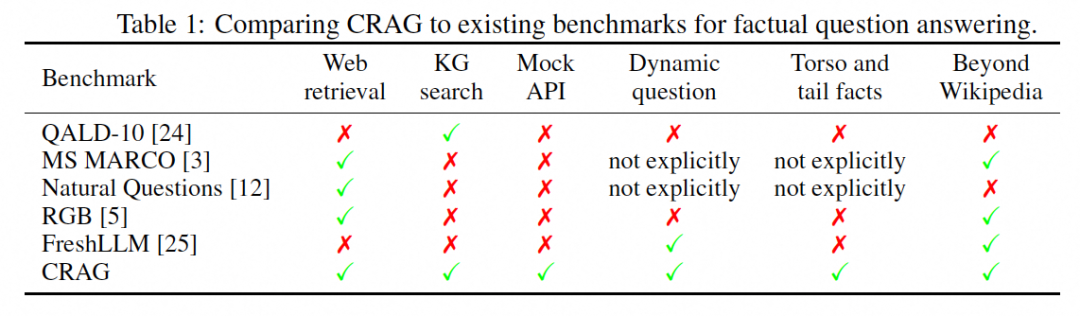

尽管如此,现有的RAG评测数据集似乎并没有充分表现出现实世界问答任务的多样性和动态性(如下图所示)。例如,一些传统问答(Question-Answering)基准数据集虽然在过去十年中推动了QA的发展,但它们并不完全适合当前RAG面临的挑战。

因此,为推动RAG领域的研究,需要构建一个全面的基准测试数据集。这个基准测试需要能够反映真实用例;包含多样化的实例类型;便于理解不同模型的性能差异;能可靠评估模型性能;并且其场景和数据不会迅速过时,能够随时间更新和改进。本文将这些特性概括凝练为五个关键特征,包括:真实性、丰富性、洞察力、可靠性和持久性。这些特征有助于确保基准测试能够有效地评估和提升QA系统的性能。

问题描述

RAG QA系统接收一个问题(Q)作为输入,并返回一个答案(A)。这个答案是由LLM根据从外部源检索到的信息或模型内部知识生成的,目的是为问题提供有用的信息,同时避免引入任何幻觉内容。

本文设计了三个任务来测试RAG的不同组成部分。这三个任务共享相同的QA对集合,但它们在检索打开方式上有所不同。

-

任务1 检索摘要:在任务1中,为每个问题提供了最多五页网页。这些网页可能与问题相关(不保证一定相关),旨在测试RAG系统生成答案的能力 -

任务2 知识图谱和网络检索增强:任务2除了提供网页外,还提供模拟API来访问模拟知识图谱的信息。模拟知识图谱存储与问题相关的结构化数据;问题的答案可能存在于模拟知识图谱中,也可能不存在。模拟API接受输入参数(通常从问题中解析出来),并从模拟知识图谱中提取出结构化数据以支持答案生成。此任务测试RAG系统如何查询结构化数据源,以及如何从不同来源综合信息 -

任务3 端到端RAG:与任务2类似,任务3也提供网页搜索结果和模拟API作为检索候选项,但提供了50个网页作为检索候选项。更大的网页集合更有可能提供必要的信息来回答问题,但同时也更有可能包含噪声。因此,任务3进一步测试了RAG系统如何对更多的检索结果进行排名。

这三个任务逐步增加难度,允许测试端到端RAG系统的不同能力。每个任务都在前一个任务的基础上增加了更多的数据或更复杂的检索要求。

CRAG数据

CRAG数据集由两部分组成:QA对和检索内容(网页内容或知识图谱数据),共计4409个QA对,其中有2,425个基于网页回答的问题,1,984个基于知识图谱回答的问题。

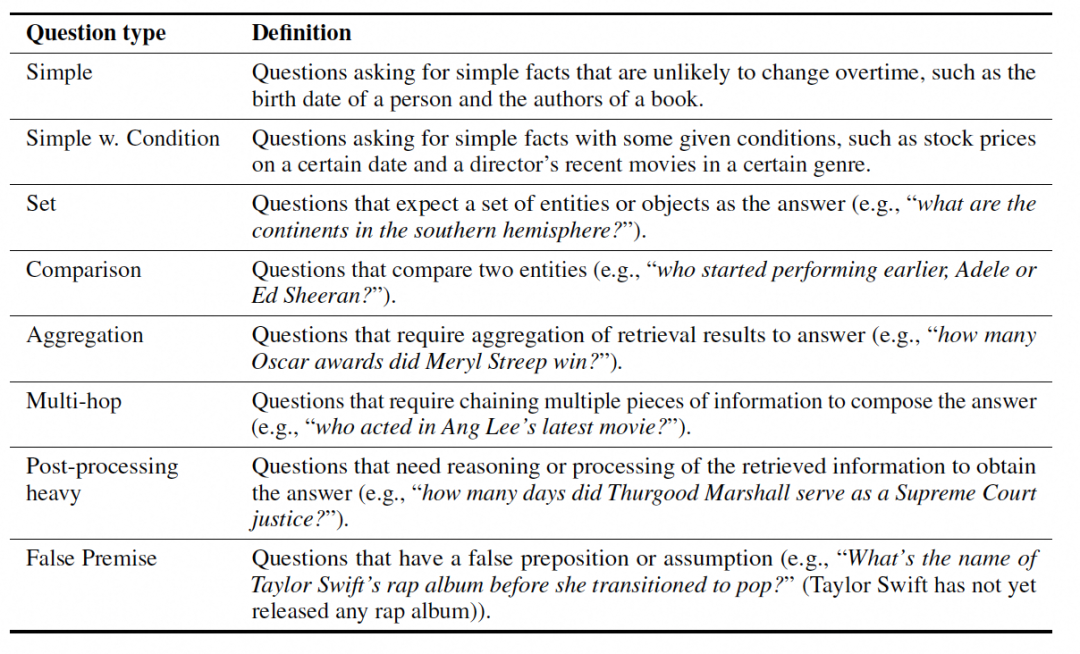

CRAG覆盖了五个领域:金融、体育、音乐、电影和开放领域,以及八种类型的问题,包括简单问题、带条件的简单问题、集合问题、比较问题、聚合问题、多跳问题、后处理问题和错误前提问题(问题定义可参考下图)。

对于每个问题,作者使用问题文本作为搜索查询,并存储了来自Brave搜索API的最多50个HTML页面。同时,作者创建了包含公开可用知识图谱数据的模拟知识图谱,通过随机选择了相同类型的实体,以及具有相似名称的“困难负样本”(hard negative)实体,用于生成问题。此外,作者还创建了具有预定义参数的模拟API,以支持在模拟知识图谱中的结构化搜索。例如,对于查询股票价格的问题,一个示例模拟API的形式是get_price_history(ticker)。

这些模拟API和网页搜索结果不仅包含必要的信息以回答基准中的一部分问题,还包含了与实体或属性名称相似的噪声数据,增加了检索和信息合成的挑战。最终,数据集包含了220K个网页,一个包含2.6M实体的知识图谱,以及38个模拟API。

评估标准

对于评估集中的每个问题,根据答案的准确性和可靠性,将其标记为完美、可接受、缺失或错误。

-

完美:回答正确且不包含任何幻觉内容 -

可接受:提供了有用的答案,但可能包含不影响答案实用性的小错误 -

缺失:回答是“我不知道”,“对不起,我找不到...”,系统错误(如空响应),或请求系统澄清原始问题 -

错误:提供了错误或不相关的信息

根据上述分类,分别给予完美、可接受、缺失和错误答案1分、0.5分、0分和-1分的评分。这种评分方法对幻觉答案给予更高的惩罚,更倾向于缺失答案而不是错误答案。对于给定的RAG系统,计算评估集中所有示例的平均得分作为最终得分。

此外,作者采用了两种评估方法:人工评估和基于模型的自动评估。

-

人工评估:人工判断每个答案完美、可接受、缺失或错误 -

自动评估:合并完美和可接受答案,称为准确答案,并使用三元评分方法,对准确、错误和缺失答案分别给予1分、-1分和0分。如果答案与真实答案完全匹配,则认为是准确的。否则,使用LLM确定。为了避免自我偏好问题,使用了两个LLM评估器:ChatGPT和Llama 3,并报告了两个模型对每个RAG系统的平均准确率、幻觉率、缺失率和得分。

通过与人工评估的比较,自动评估方法在ChatGPT上的准确率为94.7%,在Llama 3上的准确率为98.9%。

本文将数据随机分割为验证集、公共测试集和私有测试集,比例分别为30%、30%和40%,并为KDD Cup挑战赛发布了验证集和公共测试集。

评测

本文首先在CRAG公共测试集上运行了仅使用LLM的方案,测试了包括Llama2 Chat、Llama3 Instruct和GPT-4 Turbo在内的不同模型。这些模型使用了简单的提示,鼓励简洁的答案,并在置信度低时回答“我不知道”。

对于基于网页的RAG方案(任务1),作者使用了固定长度的网页上下文窗口,并按照数据中的原始顺序拼接网页片段,直到填满窗口。对于基于知识图谱的方案(任务2和3),除了使用网页搜索结果外,还使用了固定长度的知识图谱上下文窗口来包含模拟API的结果。

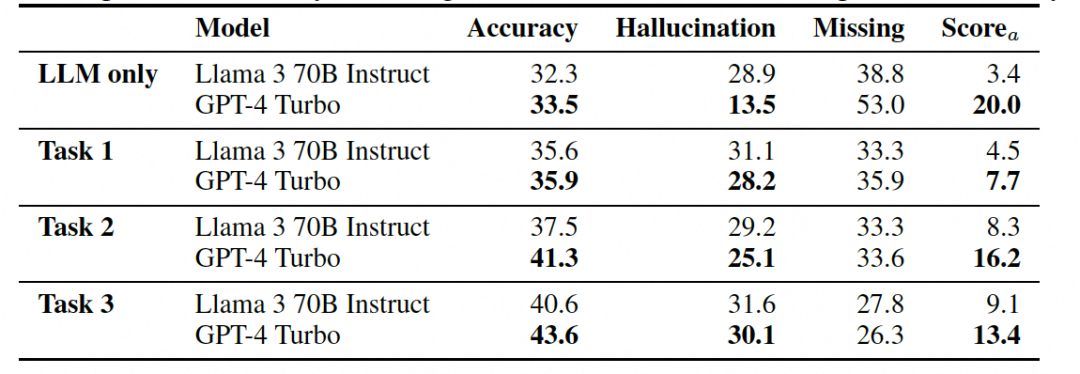

下表展示了不同模型在不同任务上的性能,包括准确率、幻觉率、缺失率和得分。结果表明,即使是最先进的LLM在CRAG上的准确率也只有34%,而直接添加RAG也只能将准确率提高到44%。

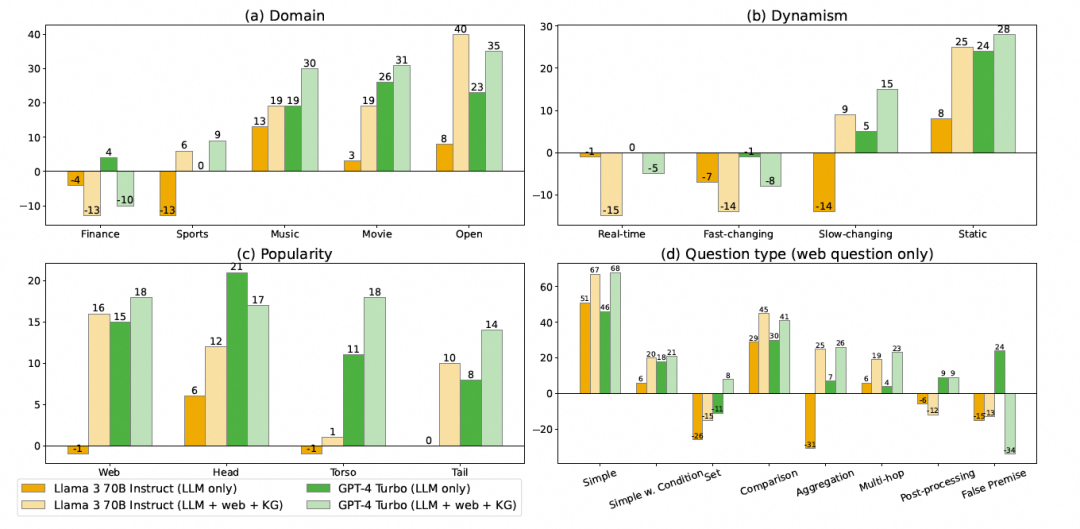

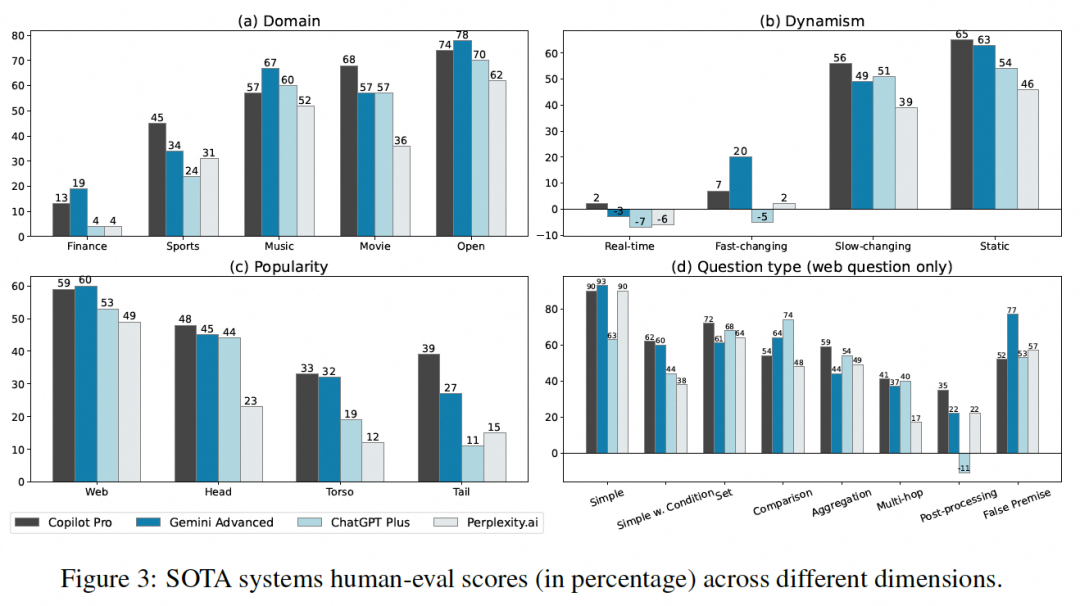

本文还展示了不同模型在不同领域(如金融、体育、音乐、电影和开放领域)、不同动态性(实时、快速变化、慢速变化和静态)、不同流行度(头部、躯干和尾部实体)以及不同问题类型(如简单问题、带条件的简单问题、集合问题等)上的性能。

通过不同维度的评估,可以观察到RAG系统在某些领域或问题类型上的性能可能显著低于其他领域或类型。例如,系统可能在处理实时问题或尾部实体问题时表现不佳。

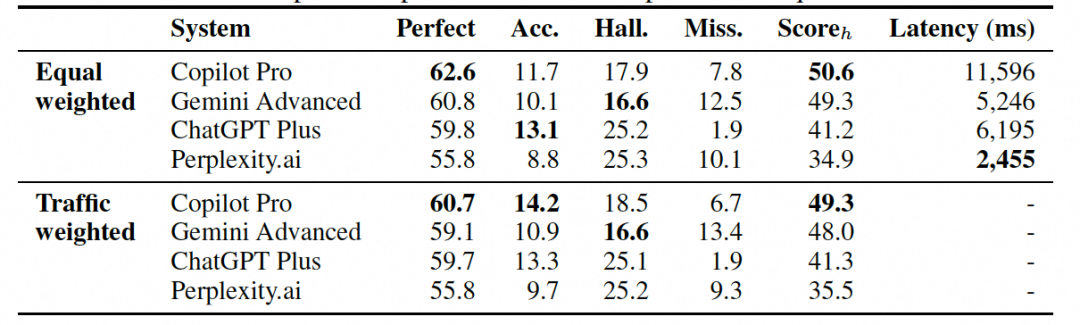

此外,本文评估了四个基于最先进LLM和搜索引擎构建的行业最先进RAG系统。其中最好的系统可以获得51%的分数,并为多达63%的问题提供完美的答案。

与直接添加RAG的方案类似,这些系统在处理动态变化快、流行度低或复杂性高的事实问题时准确率依然较低。此外,这些系统的响应时间也显示出很大的差异,从2.5秒到11.6秒不等,反映了在延迟和质量之间不同设计的权衡。这些发现表明,即使是最先进的RAG方案也存在改进的空间,特别是在提高对复杂查询的支持和减少响应时间方面。

结论与展望

CRAG的提出表明,即使是最先进的RAG系统在CRAG基准测试上的准确率也有限,这表明现有技术在理解和生成准确答案方面仍有较大提升空间,并没有我们过去想象的那么乐观! 尽管实验证明从外源检索到的信息对答案生成确实有帮助,但就和人类一样,大模型也是“重度选择困难症患者”,如何从候选结果中选择更相关的内容,并抑制不相关信息的干扰,仍然是一个重要挑战。

当然,我们也不必过分悲观,既然LLM+RAG还有很大的提升空间,对于我们AI研究者来说,未尝不是个好事,因为这就意味着还有太多太多工作值得让我们去做,除了上面提到的“选择困难症”以外,长尾问题、可信来源问题、快速变化事实都是一个一个有待攻克的难点。换个思路想想,要是现在LLM+RAG就已经能在CRAG上做到99分了,那还要我们做什么呢?因此,与大家共勉吧!

原文始发于微信公众号(夕小瑶科技说):2024KDD挑战任务,GPT-4仅得40分,Meta发布最新RAG评价基准

本网站(https://aigc.izzi.cn)刊载的所有内容,包括文字、图片、音频、视频等均在网上搜集。

访问者可将本网站提供的内容或服务用于个人学习、研究或欣赏,以及其他非商业性或非盈利性用途,但同时应遵守著作权法及其他相关法律的规定,不得侵犯本网站及相关权利人的合法权利。除此以外,将本网站任何内容或服务用于其他用途时,须征得本网站及相关权利人的书面许可,并支付报酬。

本网站内容原作者如不愿意在本网站刊登内容,请及时通知本站,予以删除。