原文始发于微信公众号(AI妙妙房):图像+音频驱动的口播视频生成!谷歌提出VLOGGER!

论文名:VLOGGER: Multimodal Diffusion for Embodied Avatar Synthesis

论文链接:https://arxiv.org/pdf/2403.08764.pdf

开源地址:https://enriccorona.github.io/vlogger/

内容创作、娱乐或游戏等行业都对人工 合成有很高的需求。然而,人类逼真视频的创作仍然很复杂,而且人工制品 已经成熟。这需要大量的手动干预才能取得实际结果。然而,完全自动化不仅 可以简化创意流程,还可以实现全新的用例,如增强的在线交流、教育或个性 化虚拟助理等。考虑到聊天代理最近的成功,后者尤其重要。研究表 明,这种解决方案被认为不够自然,不足以培养同理心,作者认 为,拟人化和行为现实主义(e.g.凝视、面部表情、全身运动)对于创造社交 形象和引发用户的同理心反应至关重要。这些功能将导致在客户服务、 远程医疗、教育 或人机交互等领域广泛采用代理。

我们提出了一种从个人的单个输入图像生成音频 驱动的人类视频的方法VLOGGER,该方法建立在最近生成扩散模型的成功基础上。我们的方法包括1)一个随机的人三维运动扩散模型,以及2)一个新颖的 基于扩散的架构,该架构通过空间和时间控制来增强文本到图像模型。这 支持生成可变长度的高质量视频,易于通过人脸和身体的高级表示进行控 制。与之前的工作相比,我们的方法不需要对每个人进行训练,不依赖于 面部检测和裁剪,生成完整的图像(不仅仅是面部或嘴唇),并考虑了广 泛的场景(e.g.可见躯干或不同的主体身份),这些场景对正确合成交流 的人类至关重要。我们还策划MENTOR了一个新的、多样化的数据集, 该数据集具有三维姿势和表情注释,比以前的数据集(800000个身份)大 一个数量级,并具有动态手势,我们在该数据集上进行了培训并做出了主 要技术贡献。

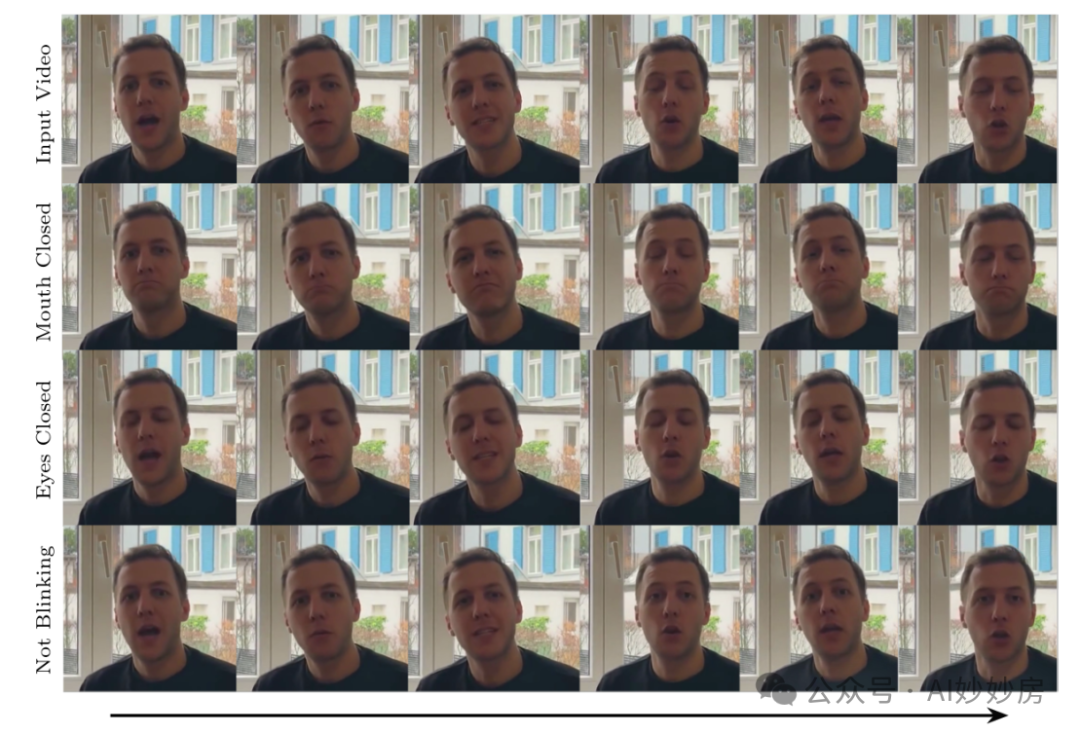

VLOGGER在三个公共基准测试中,考虑到图像质量、身份保护和时 间一致性,同时还生成上半身手势,优于最先进的方法。我们分析 了的多个多样性指标的VLOGGER性能,表明我们的架构选择和效益 的MENTOR使用在规模上训练了一个公平和公正的模型。最后,我们展 示了在视频编辑和个性化方面的应用。

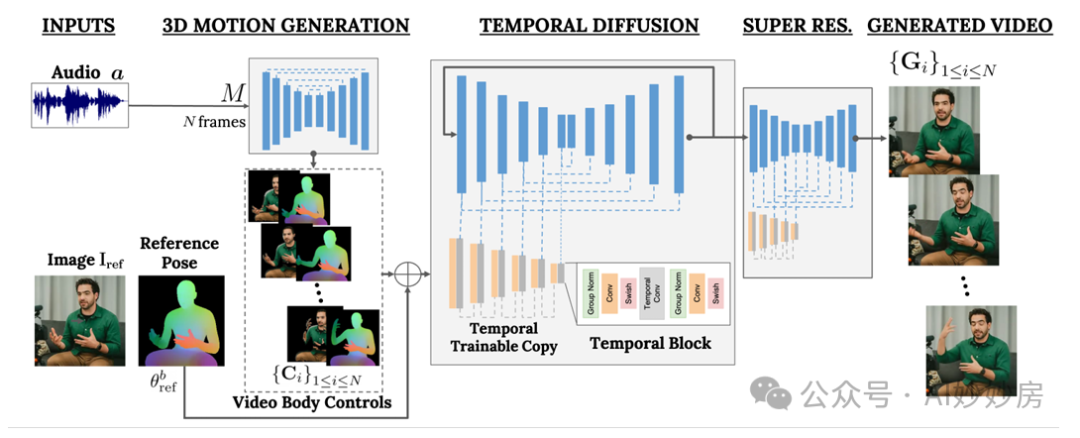

我们的目标是生成一个可变长度的真实感视频V,合成目标人物的讲话,以及 逼真的头部运动和手势。VLOGGER的框架如图所示。

VLOGGER是 一种基于随机扩散模型的两阶段流水线,用于表示从语音到视频的一对多映 射。第一网络以采样率S将音频波形a∈RNS作为输入,以生成负责目标视频长 度N上的凝视、面部表情和3D姿势的中间身体运动控制C。第二个网络是时间 图像到图像转换模型,它扩展了大型图像扩散模型,采用预测的身体控制来生 成相应的帧。为了使这个过程符合特定的身份,网络还拍摄了一个人的参考图 像。我们在新引入MENTOR的数据集上进行训练VLOGGER。

我们的流水线M的第一个网络被设计用于基于输入语音来预测驾驶 运动。我们还考虑通过文本到语音模型将输入文本转换为波形,并将产 生的音频表示为标准梅尔频谱图。M基于在时间维度上具有四个多头注意力 层的transformer架构 。我们包括对帧数和扩散步骤的位置编码,以及输 入音频的嵌入MLP和扩散步骤。在每一帧中,我们使用因果掩码使模型只关 注前一帧。该模型使用可变长度的视频进行训练,以生成超长序列,如e.g. TalkingHead-1KH数据集。

我们依靠统计和表达的3D身体模型的估计参数来产生合成视 频的中间控制表示。这些模型同时考虑了面部表情和身体运动,为人类合成更 具表现力和动态的手势打开了大门。我们任务运动生成网络基于帧i中的输入 音频ai来预测面部和身体参数M(ai)={θe i,∆θb i}。特别地,该模型生成身体姿 势θb i的表达式θe i和残差。通过预测位移,i.e. ∆θb i我们使模型能够为目标对象拍 摄具有θb i = θb ref +∆θb i参考姿势θb ref的输入图像,并为帧1 ≤ i ≤ N相对地设置人 物动画。人在几何域中的身份是由体型代码建模的。在训练和测试过程中,我 们使用通过将参数身体模型拟合到输入图像而获得的估计的3D形状参数。为了 利用基于CNN的架构的2D/3D预测,我们使用预测的表达式和姿势参数对模型 进行姿势设置,并将姿势设置体的模板顶点位置光栅化为密集表示,以获得密 集掩模Cd i 1≤i≤N ∈RH× W× 3。我们还为Nc不同的语义类光栅化身体的语义区 域。{Cm i }1≤i≤N ∈ {0,1}H× W× Nc

此外,以前的人脸再现作品通常依赖于扭曲的图像,但在基于 扩散的人类动画架构中,这些图像被忽视了。我们建议弥合这两种表示之间的差距,并使用扭曲的图像来指导生成过程,我们注意到这有助于网络 的任务,并有助于保持主体身份(请参阅Tab. 3)。我们为参考图像中可见的 每个身体顶点指定一种像素颜色,并在每个新帧中渲染身体,从而获得部分扭 曲{Cw i }1≤i≤N ∈ RH× W× 3。对于所有渲染,光栅化过程假设使用全视角相机, 具有从训练视频或参考图像推断的对角视场。

我们的下一个目标是为一个人的输入图像Iref设置动画,使其遵循先 前预测的身体和面部运动,该运动由语义、稀疏和密集的遮罩C表示。基于 这些基于图像的控制,我们提出了最先进的扩散模型 的时间感知扩展。受ControlNet的启发,我们冻结了初始训练的模型,并制作了其编码层的 零初始化可训练副本,该编码层接受输入的时间控制C。在每个下采样块的第 一层之后和第二次GroupNorm激活之前,我们在时域中交织1d个卷积层,如所 示。该网络通过获取N连续的帧和控件进行训练,并负责根据输入控件生成参 考人物的动画短片。

我们在数据集上训练我们的方法,该MENTOR数据集由独特人类受试者 的全长视频组成。因为在训练过程中,网络会取一系列连续的帧和人的任意参 考图像Iref,所以理论上我们可以指定任何视频帧作为参考。在实践中,我们对 参考进行采样,使其距离目标片段更远(在时间上),因为更近的例子会使训 练变得琐碎,并提供更少的泛化潜力。网络分两个阶段进行训练,首先在单帧 上学习新的控制层,然后通过添加时间分量在视频上进行训练。这使得能 够在第一阶段使用大批量,并更快地学习头部重演任务。对于400k两个阶段中 批量大小为128的步骤,我们以5e-5的学习率训练图像模型。

我们从一个庞大的内部视频库中整理数据集,其中包含一个扬声器,主要面向 镜头,从躯干向上,主要用英语交流。视频中24包含240的帧为24fps(10秒剪 辑),音频为16kHz。

我们的实验发现,较低和较高分辨率图像(例如, SD的128 × 128和1024 × 1024)更难训练。为了缓解 这一现象,我们使用一个简单的概率函数来在不同 训练分辨率下对图像进行采样。该函数定义为p(x) = |x −r|2/ N i |xi −r|2,其中r表示标准分辨率(例如, SD的512 ×512)。这可以提高在多分辨率训练过程中 选择较低或较高分辨率图像的概率。

为了模拟全身交流的人类,我们估计了三维身体关节和手,并通过最小化 连续帧之间的投影误差和时间差来拟合统计关节三维身体模型。我们过滤掉 背景发生有意义变化、面部或身体仅被部分检测到或其估计不稳定、手完全未 被检测到(e.g.在人类抓握和操纵物体的情况下)或音频质量低的视频。这一 过程产生了一个超过8M秒(2.2K小时)和800K身份的训练集,以及一个120小 时和∼4K身份的测试集,使其成为迄今为止在身份和长度方面使用的最大数 据集,分辨率更高。此外,该MENTOR数据集包含广泛多样的受试者(e.g.肤 色、年龄)、观点或身体可见性。中Sup.Mat.提供了统计数据以及与现有数据 集的更广泛比较。我们的目标是向更广泛的研究社区发布精心策划的视频ID、 面部贴合度和估计的身体姿势。

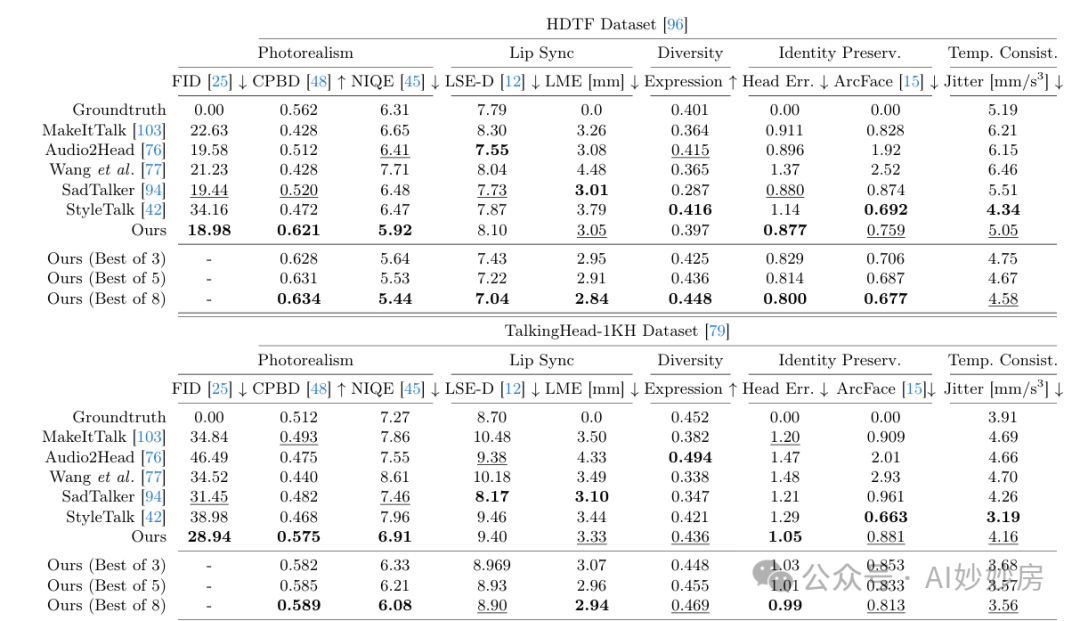

实验与结果

我们使用上述数据集上进行训练VLOGGER,基 本分辨率为,级联分辨率为和512×512。对HDTF、TalkingHead-1KH 和MENTOR的测试集进行评估。我们还在数据集上分析了我们的方法在 不同场景中的性能,并报告了它在几个多样性指标(如年龄、感知性别或肤 色)中相对于基线的性能。

表1。HDTF和和和TalkingHead-1KH数数数据据据集集集的的的定定定量量量评评评估

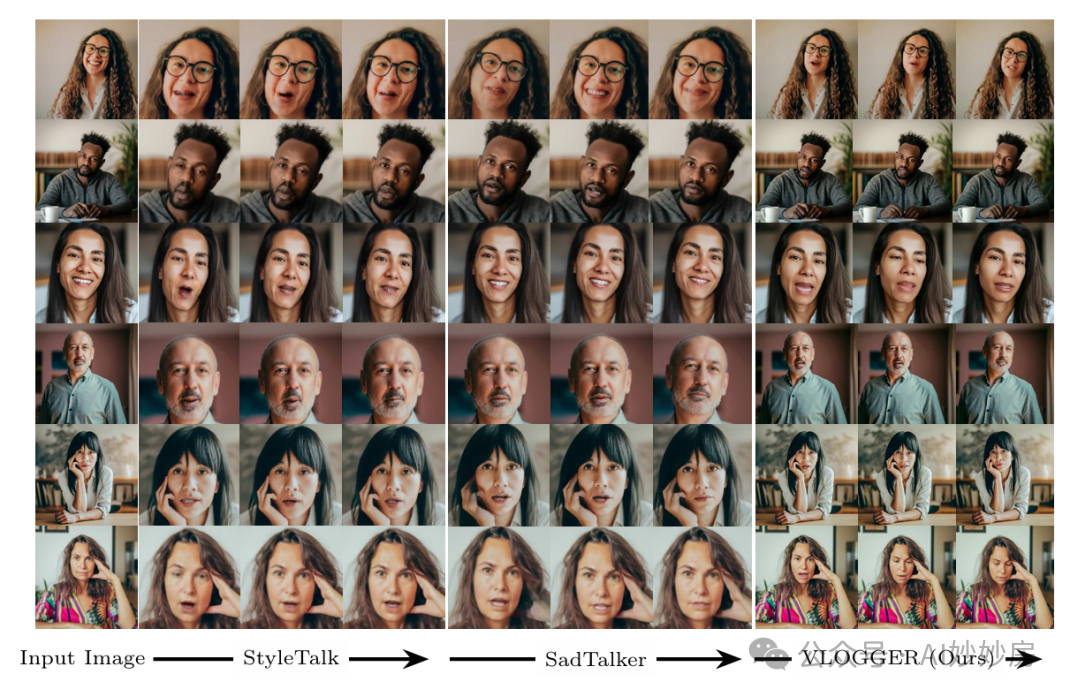

可视化结果

在本文中,我们已经提出了一种VLOGGER方法,用于从单个输入图像中合成人类视频, 包括面部和身体,该图像由音频或文本调节。VLOGGER是作为基于控制的 扩散模型的时间扩展构建的,具有基于三维人体头部和身体姿势表示的底层 支架,可以生成可变长度的高质量动画。我们引入了一个多样化的大规模数 据集(比以前的数据集大一个数量级),并验证了在该存储库和其他多个 存储库上的VLOGGER性能,表明它在人脸生成任务上优于以前的最先进技 术,并且我们的方法在不同的多样性轴上更稳健。